Vor kurzem hat Google die Katze aus dem Sack gelassen und erklärt, dass zukünftig die Ladezeiten einer Website mit zu den Rankingfaktoren gehören werden. In der Seo-Sphäre hat der neue Rankingfaktor Ladezeit sogar für ein wenig Panik gesorgt. Grund genug für das Expertenteam der Seo-Klische, sich dieses Themas anzunehmen. Ein 4-köpfiges Team unter der Leitung von Mika Shoemaker und Nick Heitzinsfeld hat unter Laborbedingungen versucht, den genauen Einfluss der Ladezeit zu erfassen. Dabei sind einige sehr überraschende Dinge zu Tage getreten.

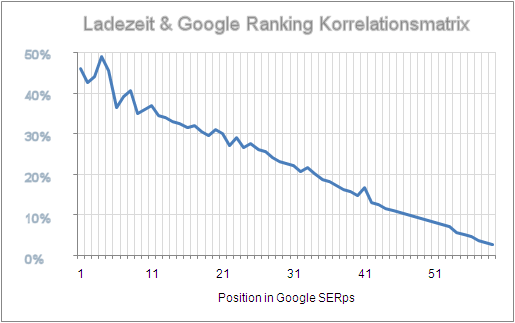

Dieses Diagramm bzw die zugrundeliegenden Zahlen machen deutlich, wie stark der Einfluss der Ladezeiten auf die Google Rankings ist. Der Einfluss ist so stark, dass chaotische Tage auf uns zukommen werden. Kleine, schlanke Seiten werden demnächst die großen, überladenen Seiten der Konzerne und Verlage überrunden. Das dürfte für viel Diskussionsstoff in den Foren und in der Presse sorgen. Wir von der Seo-Klitsche begrüßen diese Entwicklung. Zum Schluss ein Hinweis. Viele Leser werden sich fragen, wie wir überhaupt so schnell zu solch einer Auswertung kommen konnten. Und das noch vor der eigentlichen EInführung des neuen Rankingfaktors. Ganz einfach, wie üblich hat Google seinen neuen Algorithmus schon seit einiger Zeit im Livetest, natürlich nicht offen sichtbar, sondern auf einem seiner geheimen Testdatencenter, dessen Resultate dann sporadisch in den normalen Index eingeblendet und ausgemessen werden.

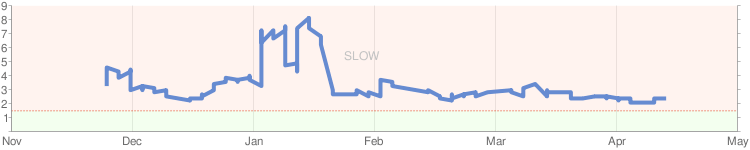

Unserem Team war es Anfang April gelungen, dieses Datencenter aufzuspüren und sich so ein Bild von der Sache zu machen. Geholfen hat uns dabei der Zufall. Beim Versuch die verschiedenen Google Datencenter im Zusammenhang mit dem PageRank Update abzufragen, fielen uns einige Ungereimtheiten auf dem Datencenter 66.77.88.99 auf, die sich mit einer klassischen PageRank Berechnung nicht mehr erklären ließen. Dadurch angestachelt, haben Mika und Nick tage- und nächtelang Testreihen aufgesetzt und ausgewertet, welche dann in den hier vorgestellten Diagrammen und Statistiken gipfelten.

Zwischenzeitlich konnten wir in Erfahrung bringen, dass die Google-internen Fachbegriffe für das weltweite Einsammeln und Auswerten der Ladezeiten unter den Bezeichnungen Speed-Dating (Sammeln der Geschwindikeitsdaten) und Tempomatrix (Datenbank der Lade-Geschwindigkeiten) laufen. Eigentlich nicht wirklich überraschend, wenn man weiss wie Google tickt ;-)

Wir arbeiten an einem neuen SEO Buch, dass dieser Entwicklung Rechnung tragen soll. Der Titel wird “SEO – Need for Speed” lauten. In Zusammenarbeit mit dem Mario Fischer Verlag soll auch eine Zeitschriften-Sonderausgabe unter dem Titel “Website Boosting – Need for Speed” herausgebracht werden. Weiterhin stehen wir in Verhandlung mit Fridaynite, in dessen SEO Ebook die Neuerungen ebenfalls mir einfließen sollen. Ihr seht, so viel Bewegung im Seo-Business hat es schon lange nicht mehr gegeben.

Wir freuen uns schon auf „Need4Speed“ und die Tacho-Toolbar – auch wenn ihr einen Drehzahlmesser zeigt ;-)

Mag die Korrelation zwischen Speed und Ranking vorhanden sein, so muss es aber nicht zwangsläufig auch um Kausalität handeln. Folgende Faktoren spielen vielleicht auch eine Rolle:

– Große Firmen betreiben Load-Balancing mit mehreren Webservern, erreichen dadurch eine optimale Performance. Große Firma=starker Brand=viele Links

– Kleine Mitbewerber können sich aufwendige Servertechnik nicht leisten und hantieren deshalb mit Webspace oder VServer herum. Klarer Nachteil in Sachen Geschwindigkeit

– die breite Masse der User nutzt quelloffene Systeme (z. B. Wordpress) und stopfen sie mit speed-deoptimierten Plugins voll. Große kommerzielle CMS exportieren standardmäßig in Plain-HTML (z. B. Reddot). Wordpress muss jedesmal durch einen PHP-Interpreter gejagt werden. Klarer Nachteil für die „Kleinen“

Ohne euer Messverfahren genau zu kennen, kann man da wenig zu sagen. Grundsätzlich halte ich es aber wie Torsten. Die Seiten die in den SERPs zu halbwegs geldbringenden Keywords vorne stehen kommen von Seiten, deren Betreiber sich ein saubereres System und eine bessere Infrastruktur leisten.

Der Normalo-Webseitenbetreiber wählt den nächstbesten günstigen Webspace und hat gar nicht die Einsicht und Kompetenz wie er mehr rausholen kann. Das bezieht sich ja nicht nur auf Speed.

Je nach Website ist statischer Export aber auch nicht der Weisheit letzter Schluss. Hast du emsige große Redaktionen und womöglich User Generated Content verbrätst du deine Ressourcen beim Versuch den statischen Export auf dem Laufenden zu halten.

Vollkommen plausible Werte, sehe ich genau so.

… einfach köstlich dieser Artikel, was habe ich ich gelacht.

In Zukunft werden wir txt. files als Webseiten auf die Server jagen und MS-DOS nachinstallieren, damit es Google schneller hat . Back to the roots…